(English version below).

„Was ist Eyetracking?“ fragte ein Familienmitglied, nachdem ich skizziert hatte, woran ich gerade arbeite. „Die Blickerfassung, eine Methode,“ lautete mein schneller Elevatorpitch.

Heute geht es um die Frage: Was ist eigentlich Eyetracking? Und wie lässt sich das in der Wissenschaft und Praxis anwenden? Wir werfen einen Blick in den Methodenkoffer. Zuerst schauen wir die visuelle Wahrnehmung an, dann das Messen und Analysieren mit einem Eyetracker, und schliesslich die Anwendung.

Die Visuelle Wahrnehmung

Wenn wir „sehen“, nimmt unser Auge durch die Pupille das Licht wahr, das von Objekten im Raum reflektiert wird. Das Bild wird anders herum gedreht und auf die Netzhaut projiziert. Die Netzhaut wandelt das Licht in Nervenimpulse um (die Geschichte mit den Stäbchen und Zapfen). Sie schickt die Information über den Sehnerv zum Gehirn. Dort wird das Wahrgenommene ausgewertet. Eine Vielzahl von kognitiven Prozessen unterstützt uns, um uns an das, was wir wahrnehmen, auch zu erinnern.

Wir sehen nur in einem kleinen Feld Details (z.B. die Farbe und Schärfe von Objekten). Alles andere wird unscharf und farblos peripher wahrgenommen. Aber auch im peripheren Sehen nehmen wir Informationen aus der Umwelt auf. Wir erkennen z.B. Unterschiede in der Helligkeit und nehmen Bewegungen wahr.

Das Auge funktioniert nicht wie ein Scanner, der alles gleichzeitig erfasst. Stattdessen springt der Blick durch den Raum. Während ihr diesen Text lest, springt euer Auge sehr schnell zwischen einzelnen Wörtern herum:

Stimmt, da fehlte vielleicht ein „den“ zwischen den Wörtern „zwischen“ und „einzelnen“. Vielleicht hätte euer Auge an dieser Stelle länger zwischen seinen Sprüngen pausiert, wären dies reale Daten gewesen. Dieses Springen wird im Eyetracking eine „Sakkade“ genannt. Innerhalb des Sprungs der Sakkade sehen wir nichts.

Im Marketing sind Designerinnen und Designer oft interessiert daran, ob ihre Reklame funktioniert. Und manchmal schauen Menschen tatsächlich darauf, auch wenn sie das gar nicht wollen.

Um Informationen um uns herum zu sehen, muss der Blick durch den Raum wandern. Ihr habt bestimmt schon bemerkt dass ihr kein Ruckeln in eurer Sicht erlebt? Stimmt. Denn unser Gehirn korrigiert das. Es verbindet das Wahrgenommene und spielt uns vor dass nichts ruckelt.

Zwischen den Sakkaden gibt es Pausen (Fixationen), um Informationen aus der Umwelt aufzunehmen. „Pause“ ist jedoch kein akkurates Wort, da das Auge nicht komplett still steht, sondern sich minimal bewegt (Tremor, Microsakkade, Drift). In der Fixationszeit wird Information direkt wahrgenommen.

Durch das Eyetracking können wir die Sprünge und die Pausen des Auges messen und die Blickbewegungen auswerten. In Kürze kann man das Alles so zusammenfassen:

Das Auge erfasst den Raum, um zu sehen.

Eyetracking erfasst die Blickrichtung des Auges.

Das Messen der Blickrichtung

Eyetracking gibt es schon seit dem späten 19. Jahrhundert. Es war damals technisch sehr aufwändig – und ziemlich unangenehm. Aber es war schon erfunden.

Eine Alternative war das manuelle Aufzeichnen der Blickrichtung. So stellte Yarbus (1967) fest, dass Menschen ein Bild abhängig von der Aufgabe, die sie vom Forscherteam bekamen, anders betrachteten. Der Blick hinterliess also je nach Aufgabe andere Bewegungsmuster, wie hier von einer/m Teilnehmenden zu sehen:

In den siebziger Jahren wurde das bis dahin noch nicht mobile Eyetracking technisch verbessert, sodass die Herstellfirmen ihre neue Zielgruppe fanden: Besonders in der Marktforschung fand das Eyetracking als Evaluations-Werkzeug ein hohes Ansehen.

Erst im letzten Jahrzehnt entstanden auch mobile Eyetracking-Geräte – von nur einer Handvoll darauf spezialisierter Firmen, von denen einige schon nicht mehr existieren. Mittlerweile sehen Eyetracking-Geräte wie eine Brille aus, in denen mehrere Kameras installiert sind. Sie sind leicht und behindern die Sicht kaum noch. Ein Kabel sichert die Daten auf einem Tablet oder Smartphone.

Die Messung funktioniert in den meisten Fällen über nahes Infrarotlicht, das auf die Augen gerichtet wird. Der Eyetracker erfasst die Reflektionen des nahen Infrarotlichts auf dem Auge. Eine Kamera identifiziert die Reflexion der Lichtquelle auf der Hornhaut. Ein Algorithmus rechnet den Winkel zwischen Hornhaut- und Pupillenreflexion aus. Daraus wird die Blickrichtung abgeleitet.

Die Blickrichtung wird einer Software als Bild oder Video visualisiert. Diese kann man sich für eine erste, qualitative Auswertung anschauen. Es ist jedoch ebenfalls wichtig, die Eigenschaften der Blickbewegung auch quantitativ zu analysieren: Wohin wurde als erstes geschaut, wie lange, und worauf fiel der Blick danach? (Fixations-Analyse)

Das Analysieren der Blickrichtung

Eyetracking-Analysen kosten viel Zeit und einiges an technischen und inhaltlichen Knowhow. Denn obwohl Eyetracking sich direkt auf unsere visuelle Wahrnehmung und indirekt auf unsere Aufmerksamkeits-Prozesse bezieht, kann eine Analyse nie aussagen, was ihr gerade denkt (Notiz: ich kenne keine Methode, die das kann).

Stellt Euch z.B. vor ihr steht an einer Ampel und schaut auf die rote Figur. Der Eyetracker misst in dieser Zeit eine Fixation, die man in den Analysen erkennen kann. Aber ihr denkt an euer Abendessen. Wie dieses Beispiel zeigt, kann es also vorkommen, dass der Eyetracker eine Fixation auf ein Objekt misst, ohne dass die jeweilige Person sich später daran erinnert. Ebenfalls kann es vorkommen, dass Menschen sich an Dinge erinnern, die sie in der Studie zwar kaum angeschaut, aber peripher (ohne Details) durchaus wahrgenommen haben. Deswegen muss die inhaltliche Plausibilität der Daten stets überprüft werden.

Eine andere Gefahr bei der Eyetracking-Analyse ist: Es kann unglaublich spannend sein, einen Gaze-Replay oder eine Heatmap der Blickbewegungen anzuschauen. Denn intuitiv sieht es so aus, als sähe man mit den Augen der jeweiligen Person auf die Welt. Das Auge springt zwischen Objekten und dabei fühlen wir uns ganz nahe dran an der Wahrnehmung der Anderen; „aha, so nimmt der/diejenige die Welt also wahr!“

Leider funktioniert das nicht so. Denn wenn wir basierend auf den Eyetracking-Daten aussagen, „schau, sie/er fand dieses einzigartige Detail meiner aufwändig gestalteten Fassade interessant/einfach zu verstehen/memorabel“, dann ist das nicht zwangsläufig so (backward reasoning with affirmative bias). Gerade wenn es viele Faktoren gibt, die einen Einfluss auf die individuelle Wahrnehmung und das Erleben haben, ist es schwierig, diese im Detail experimentell zu kontrollieren und in ihren komplexen Zusammenhängen auszuwerten. Vielleicht war es der Lichteinfall, der ein interessantes Schattenspiel auf der Fassade erzeugte. Oder vielleicht war es einfach gar nichts, und die Teilnehmerin schaute die Fassade zwar an, aber dachte an ihr Abendessen. Deswegen hilft es, verschiedene Methoden mit den Eyetracking-Daten zu kombinieren.

Wir müssen in der Feldforschung akzeptieren, dass es einen gewissen Grad des Kontrollverlusts gibt. Aber: wenn wir dadurch besser verstehen, wie Menschen sich in Räumen verhalten (und die Komplexität der Beziehungen zwischen Mensch und Raum besser abbilden können), dann ist das vielleicht gar nicht so schlimm?

Einige Anwendungsbeispiele

Mobiles Eyetracking bedeutet, dass wir die Blickbewegung messen, während sich der Kopf unabhängig von der Laufrichtung bewegt, und es sehr viele Objekte im Raum gibt, auf die die Aufmerksamkeit potenziell gerichtet werden kann. Einige Anwendungsbeispiele sind:

- Aufgaben am Computer lösen, um z.B. Produkte, Webseiten, und Werbung zu optimieren (z.B.: „Hat der/die Teilnehmende dahin geschaut wo wir es erwartet haben“?; „Wie lange war der Blick auf mein Produkt gerichtet, statt auf das Produkt meiner Konkurrenz?“; „Wie kann ich ‚Banner-Blindness‘ verringern, sodass Menschen meine Werbung nicht ignorieren?“)

- Eine neue Beschilderung im Raum bereits vor dem Bau zu vergleichen („Ist Schild-Variante A oder B in meiner Simulation klarer, weil der Blick weniger umher schweift, also direkter Informationen findet?“)

- Führerschein-Novizen und Expertengruppen in ihrer Wahrnehmung des Strassenraums und darauf basierenden Fahr-(Fehl-)Entscheidungen zu vergleichen („Richten Expertengruppen vorausschauend den Blick in die Kurve und Neulinge eher auf den Nahbereich und die Distanz zum nächsten Fahrzeug?“)

- Games und Entertainment optimieren („Wohin richten Spielende den Blick in meinem virtuellen Raum und kann ich ein neues Spiel entwickeln, das auf der Augenbewegung basiert“?)

- Sprachausgaben und mobile Hilfsmittel mit den Augen steuern, z.B. für Menschen mit körperlichen Einschränkungen („Wenn eine Person nur die Augen bewegen kann, mit welchem Interaktions-Design kann sie/er dann am Schnellsten mit den Augen Texte formulieren und den Rollstuhl bewegen?“)

Ich könnte Euch z.B. einladen, meinen Blog anzuschauen, während ihr eine Eyetracking-Brille tragt, die Eure Blickbewegung misst. Vielleicht würde ich dabei merken, dass ihr die Bilder (nicht) anschaut, ganze Passagen überfliegt, oder einige Fachwörter sehr lange anschaut. Am besten wäre es, wenn ich euch plausible Aufgaben geben würde („Finde einen Bericht über Ältere Menschen„) und ebenfalls frage, wie einfach oder schwer bestimmte Aufgaben zu lösen waren, wie ihr euch gefühlt habt, wie gut ihr bereits mit der Webseite vertraut wart (usw.). Solche Daten würden mir etwas bringen, wenn ich verschiedene Varianten (z.B. im Layout) vergleiche, genug Freiwillige frage, und eine gute Hypothese darüber hätte, was ihr hier vermutlich sucht und wie (A oder B) ich das optimieren kann.

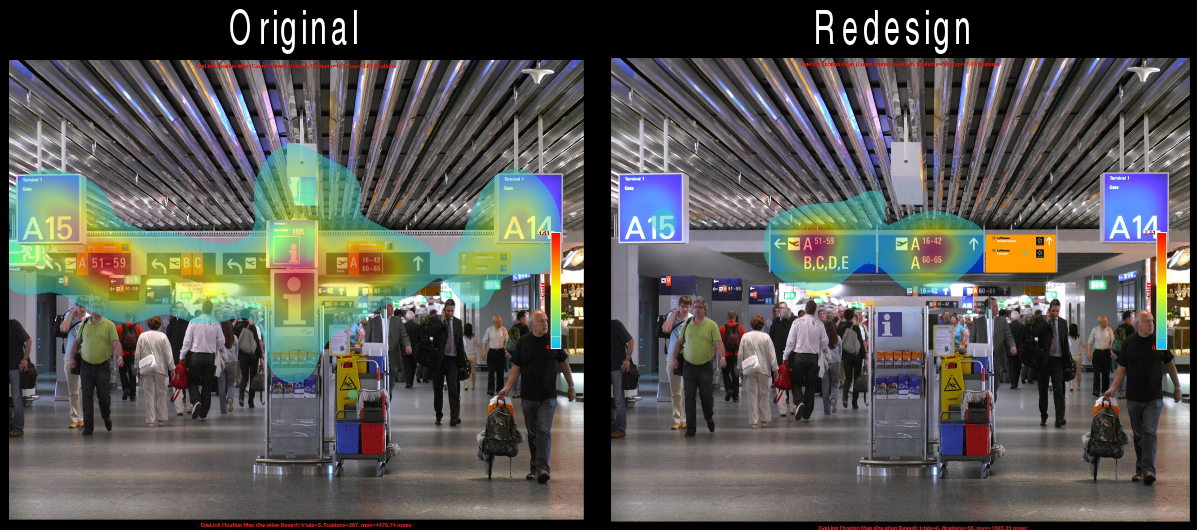

In einer Studie meiner ehemaligen Kollegin wurden Teilnehmende gebeten, so schnell wie möglich zu entscheiden, in welche Richtung sie sich wenden würden um ein Gate am Flughafen zu finden (Schwarzkopf et al., 2013). Die Reaktionszeiten und Blickbewegungen im Labor und im Feld zeigten, dass Teilnehmende weniger Wegfindungs-Fehler machten, sich schneller entscheiden konnten, und besser auf die relevanten Informationen auf den Schildern fokussierten, wenn eine neue Variante der Beschilderung angebracht war. Auch vertrauten die Teilnehmenden ihren Entscheidungen mehr. Hier ein Beispiel aus einer ähnlichen Studie des Teams: im Redesign fokussiert eine Person mehr als im Original, wo der Blick suchend ist.

Zurzeit messe ich mit Eyetracking ebenfalls, wie der Raum während den Wegfindungs-Entscheidungen wahrgenommen wird und worauf der Blick fällt. Bis ich das ausgewertet habe, wird es noch viele Monate dauern. Im Jahr 2020 berichte ich hier vielleicht davon.

Fun fact: Die pausierte Uhr

Zum Abschluss ein bisschen Spass: Die Illusion der pausierten Uhr.

Kennst du das, wenn Du eine analoge Uhr anschaust und der Sekundenzeiger länger als eine Sekunde zu frieren scheint, bevor er weiter tickt?

Das liegt an der Wahrnehmung. Die Augen bewegen sich (wie oben beschrieben) punktuell, als Sakkaden. Innerhalb des Sprunges, während du die analoge Uhr anschaust, meint Dein Gehirn, dass die Uhr länger angeschaut wurde, als sie in Wirklichkeit angeschaut wurde. Dies geschieht, wenn eine Sakkade von einem Fixierpunkt zu dem nächsten Fixierpunkt springt, ohne dass wir diesen Sprung bemerken. Da unser Gehirn ziemlich schlau ist, füllt es Informationen ein die wir gar nicht sehen, damit das Bild nicht ruckelt (perceptual gap). Daher kommt die Illusion, dass der Zeiger länger als eine Sekunde zu stehen scheint (vgl. auch Yarrow et al., 2001).

Fazit: was ist Eyetracking?

Der erste Schritt im Methodenkoffer ist getan: Wir haben das Eyetracking kennengelernt.

- Eyetracking ist das Messen der Blickbewegung. Das geht am Computer und auch Mobil. Meistens ist der Eyetracker auf einer Brille installiert.

- Anwenden lässt sich diese Methode immer dann, wenn wir an der visuellen Wahrnehmung interessiert sind. Wir wissen zwar nicht, was die Leute denken, aber wir sehen, wohin der Blick in Raum fällt.

Unten sind wissenschaftliche Artikel zum Weiterlesen verlinkt.

Wie immer freue ich mich auf Eure Kommentare. Was würdet ihr mit der Methode des Eyetracking gerne erforschen? Kommentiert gerne unten.

Weiterlesen? Wie immer gerne!

Wissenschaftliche Arbeiten von unserem Team

Flughafen

- Schwarzkopf, S., von Stülpnagel, R., Büchner, S. J., Konieczny, L., Kallert, G., & Hölscher, C. (2013, September). What lab eye tracking tells us about wayfinding a comparison of stationary and mobile eye tracking in a large building scenario (Seite 31!). In Eye Tracking for Spatial Research, Proceedings of the 1st International Workshop (in conjunction with COSIT 2013) (pp. 31-36).

- Buechner, S. J., Wiener, J., & Hölscher, C. (2012, March). Methodological triangulation to assess sign placement. In Proceedings of the Symposium on Eye Tracking Research and Applications (pp. 185-188). ACM.

Wegfindung

- Schnitzler, V., Giannopoulos, I., Hölscher, C., & Barisic, I. (2016, March). The interplay of pedestrian navigation, wayfinding devices, and environmental features in indoor settings. In Proceedings of the Ninth Biennial ACM Symposium on Eye Tracking Research & Applications (pp. 85-93). ACM

Museumsgestaltung

- Krukar, J., (2015). The Influence of an Art Gallery’s Spatial Layout on Human Attention to and Memory of Art Exhibits. Dissertation. Northumbria University.

Und, etwas Geduld, im Jahr 2020/21 dann auch von mir 🙂

und weiter:

Ein Klassiker

- Yarbus, A. L. (1967). Eye movements during perception of complex objects. In Eye movements and vision (pp. 171-211). Springer, Boston, MA.

Die pausierte Uhr Illusion

- Yarrow, K., Haggard, P., Heal, R., Brown, P., & Rothwell, J. C. (2001). Illusory perceptions of space and time preserve cross-saccadic perceptual continuity. Nature, 414(6861), 302.

English version

Translation not by me 😉 but via DeepL. Minor changes between the versions due to mild editing. You can chose to translate yourself 😉

„What is Eyetracking?“ asked a family member after I sketched out what I was working on. „The eye tracking, a method,“ was my fast elevator pitch.

Today the question is: What is eye tracking? And how can this be applied in science and practice? Let’s take a look at the toolbox. First we look at the visual perception, then the measuring and analyzing with an eyetracker, and finally the application.

Visual perception

When we „see“, our eye perceives through the pupil light that of objects in reflected light. The resulting image is rotated the other way around and projected onto the retina. The retina converts the light into nerve impulses (the story of rods and cones). It sends the information via the optic nerve to the brain. There the perceived is evaluated. A multitude of cognitive processes supports us in reminding us of what we perceive.

We only see details in a small field (e.g. the colour and sharpness of objects). Everything else is perceived blurred and colorless peripherally. But also in peripheral vision we absorb information from the environment. For example, we recognize differences in brightness and perceive movements.

The eye does not function like a scanner that captures everything at the same time. Instead, it jumps very quickly between the individual points in space. As you read this text, your eye quickly jumps between words:

First image above: Eyetracking Gazeplot (fictitious data and representation)

True, there was no „the“ between the words „between“ and „words“ in the above text. Maybe your eye would have paused longer between its jumps if it had been real data.

In marketing, designers are often interested in whether their advertising works. And sometimes people actually look at it, even if they don’t want to.

Check the second image above.

This jumping is called a „saccade“ in eye tracking. In the saccade we see nothing. You probably already noticed that you don’t see any jerking in your view? That’s right. Because our brain corrects that. It connects the perceived and simply pretends that nothing jerks.

To see information around us, the gaze has to wander through space. Between the saccades there are pauses (fixations) to absorb information from the environment. However, „pause“ is not an accurate word, because the eye does not stand completely still, but moves minimally (tremor, microsakcade, drift).

In a nutshell, this can be summarized as follows:

The eye grasps the space to see.

Eyetracking captures the direction of the eye.

Measuring the viewing direction

We can measure the jumps and pauses of the eye: Eye tracking has been around since the late 19th century. Although it was technically complex and rather unpleasant at that time, it was already invented.

One alternative was manual recording. For example, Yarbus (1967) found that people view an image differently depending on the task they receive from the research team. The gaze left behind different patterns of movement depending on the task:

Second image above: Manual eyetracking in Yarbus (1967)

In the seventies, eye tracking was improved by laboratory devices, so that the device manufacturers found a new target group.

It was only in the last decade that mobile eye tracking devices (from only a handful of specialized companies, and some that are no longer in existence) were developed.

Meanwhile, eyetracking devices look like one pair of glasses in which several cameras are installed. They are light and hardly obstruct the view. A cable secures the data on a tablet or smartphone.

In most cases, the measurement works via near infrared light directed at the eyes. The eye tracker detects the reflections of near infrared light on the eye. A camera identifies the reflection of the light source on the cornea and an algorithm calculates the angle between corneal and pupil reflection. The viewing direction is derived from this.

The viewing direction can be visualized with software as an image or video. This can be viewed for an initial qualitative evaluation. However, it is more important to analyze the characteristics of the eye movement quantitatively: Where was the first look taken, how long, what did the eye look at afterwards? (fixation analysis)

Analyzing the viewing direction

Eyetracking analyses cost a lot of time and some technical and content-related know-how. Because although eyetracking refers directly to our perception and attention processes, an analysis can never say what you are thinking (I don’t know any method that can guess thinking).

For example, imagine yourself standing in front of it at a traffic light and looking at the red figure. The eye tracker measures a fixation in time. But you are thinking about your dinner. As the example shows, it can happen that the eye tracker shows a fixation on an object without the study participants remembering it later or the fixed object being relevant for the researcher’s question. It is also possible that study participants remember things that they hardly looked at in the study, but perceived peripherally (without details).

One challenge of eye tracking analysis is that it can be incredibly exciting to look at a gauze replay or a heat map of eye movements. Because intuitively it looks like looking at the world with the eyes of the respective person. The eye jumps between objects and we feel very close to the perception of the other; „aha, that’s how the person perceives the world!„

Unfortunately it doesn’t work that way. Because if we say, „look, she/he found this unique detail of my elaborately designed facade interesting/simple to understand/memorable“, then this is not necessarily so (backward reasoning with affirmative bias).

Especially if there are many factors that have an influence on individual perception and experience, it is difficult to control them experimentally in detail and to evaluate them in their complex contexts. Perhaps it was the incidence of light that created an interesting shadow play on the façade. Or maybe it was just nothing, and the participant looked at the façade but thought of her dinner.

We have to accept in field research that there is a degree of loss of control. But if it gives us a better understanding of how people behave in spaces (and how they can better define the complexity of relationships between people and space), then maybe it’s not so bad.

Application examples

Mobile eye tracking means that we measure the eye movement while the head moves independently of the direction of movement, and there are many objects in space that can be focused on.

Some examples of applications in cognitive science and psychology are:

- Solving tasks on the computer, e.g. optimizing products, websites, and advertisements (e.g: „Did the participant look where we expected it to look“ and „How long was the focus on my product instead of my competitor’s product?“)

- To compare the advantage of a new signage in a new airport terminal before the construction in virtual space („Is variant A or B clearer, because the gaze wanders less around, thus finding direct information?“)

- To compare novice drivers and expert groups in their perception of the road space and the driving decisions based on it („Do expert groups look ahead into the bend and newcomers rather at the close range and the distance to the next vehicle?“)

- Optimize games and entertainment („Where do gamers look in my virtual space and can I develop a new game based on eye movement?“)

- Control speech output and mobile aids with the eyes, e.g. for people with physical limitations („If a person can only move the eyes, with which interaction design can he/she formulate texts with the eyes and move the wheelchair most quickly?“)

For example, I could invite you to look at my blog while wearing eye-tracking glasses that measure your eye movement. Maybe I would notice that you (don’t) look at the pictures, fly over whole passages, or look at some technical terms for a very long time. It would be best if I would give you plausible tasks („Find a report about older people“) and also ask how easy or difficult certain tasks were to solve, how you felt, how well you were already familiar with the website (etc.). Such data would only help me if I compared different variants (e.g. layout), asked enough volunteers, and had a good idea about what you’re probably looking for on the blog.

Third image above: Example: Comparative study of signs in the lab: variants in the signage indicate more efficiency in the right variant, where the view is much more focused than links, where the participant is looking for information despite signs.

Image source: Spatial-Cognition.org; cf. also Schwarzkopf et al. (2013)

In a study by a former colleague, participants were asked to decide as quickly as possible in which direction they would turn, e.g. to find a gate at the airport (Schwarzkopf et al., 2013). The reaction times and eye movements in the laboratory and in the field showed that participants made fewer mistakes in finding their way, could decide more quickly, and could focus better on the relevant information on the signs if the new, not old, signs were attached. The gaze was then less searching and the participants trusted their wayfinding decisions more.

Currently, I also use eye tracking to measure how the space is perceived during the wayfinding decisions and where the gaze falls. It will be many months before I have evaluated this. Maybe I will report on it here in 2020?

Fun fact: the paused watch

Finally a little fun: The illusion of the paused clock.

Do you know that when you look at an analog clock and the second hand seems to freeze for more than a second before it continues ticking?

This is, again, due to perception. The eyes move from point to point (as described above), as saccades. Within the jump, while you are looking at the analog clock, your brain says that the clock was looked at longer than it was actually looked at, when a saccade jumps from one fixation point to the next fixation point, without us noticing that jump. So since our brain is pretty smart, it fills in information here that we don’t actually see so that the image doesn’t jerk (perceptual gap). Hence the illusion that the hand seems to stand longer than one second (cf. also Yarrow et al., 2001).

Conclusions

The first step in the method kit has been taken: We got to know eye tracking.

Fourth image above: An eye tracking device / my hands.

Picture source: P.Mavros

- Eyetracking is the measurement of the eye movement. This can be done on the computer and also mobile in space. Usually the eyetracker is installed on a pair of glasses.

- This method can be used whenever we are interested in visual perception and decisions. We don’t know what people think, but we see where the gaze in space turned.

Below are scientific articles to read more. And: As always I am happy about your comments: what would you like to explore with the eyetracking method?

Translation not by me 😉 but via DeepL.

Read more? Sure!

Research by our team

Airport

- Schwarzkopf, S., von Stülpnagel, R., Büchner, S. J., Konieczny, L., Kallert, G., & Hölscher, C. (2013, September). What lab eye tracking tells us about wayfinding a comparison of stationary and mobile eye tracking in a large building scenario (Seite 31!). In Eye Tracking for Spatial Research, Proceedings of the 1st International Workshop (in conjunction with COSIT 2013) (pp. 31-36).

- Buechner, S. J., Wiener, J., & Hölscher, C. (2012, March). Methodological triangulation to assess sign placement. In Proceedings of the Symposium on Eye Tracking Research and Applications (pp. 185-188). ACM.

Wayfinding

- Schnitzler, V., Giannopoulos, I., Hölscher, C., & Barisic, I. (2016, March). The interplay of pedestrian navigation, wayfinding devices, and environmental features in indoor settings. In Proceedings of the Ninth Biennial ACM Symposium on Eye Tracking Research & Applications (pp. 85-93). ACM

Museum design

- Krukar, J., (2015). The Influence of an Art Gallery’s Spatial Layout on Human Attention to and Memory of Art Exhibits. Dissertation. Northumbria University.

and, patience friends, around 2020/21 also some work from me.

other work

A classical study:

- Yarbus, A. L. (1967). Eye movements during perception of complex objects. In Eye movements and vision (pp. 171-211). Springer, Boston, MA.

The paused watch illusion

- Yarrow, K., Haggard, P., Heal, R., Brown, P., & Rothwell, J. C. (2001). Illusory perceptions of space and time preserve cross-saccadic perceptual continuity. Nature, 414(6861), 302.

Sehr interessant.

Wirklich faszinierend wie meine Augen beim Lesen des Beispieltextes hin- und hergesprungen sind.

LikeGefällt 1 Person

🙂

LikeLike